In principio fu Siri, l’assistente intelligente lanciato per la prima volta da Apple nel 2011 e già pensato per farci svolgere meglio e più in fretta una serie di operazioni semplici, come cercare un numero sulla rubrica, chiamare qualcuno o mettere la sveglia per il giorno successivo. Era il primo vero assistente vocale della storia – o perlomeno il più vicino ai modelli che oggi conosciamo – e arrivava dopo una serie di innovazioni che dal 1961 avevano visto altre realtà come IBM, Carnegie Mellon University e Microsoft introdurre i primi tool di speech recognition, il riconoscimento vocale. Da allora lo scenario è a dir poco cambiato e la voce sta diventando l’interfaccia naturale attraverso cui interagiamo con la tecnologia.  In meno di un decennio, la concorrenza a Siri si è fatta spietata, complice la comparsa sul mercato di Cortana, Alexa, Google Assistant e di altri assistenti vocali usati in ambito business. Inoltre i vocal assistants stanno diventando empatici ed efficienti, imparando sempre meglio a capirci e a venirci in soccorso quando digitare su una tastiera sarebbe complicato – e quindi quando abbiamo le mani occupate (per esempio se stiamo guidando un’automobile) o sporche, oppure semplicemente preferiamo parlare a voce invece di digitare su una piccola tastiera.

In meno di un decennio, la concorrenza a Siri si è fatta spietata, complice la comparsa sul mercato di Cortana, Alexa, Google Assistant e di altri assistenti vocali usati in ambito business. Inoltre i vocal assistants stanno diventando empatici ed efficienti, imparando sempre meglio a capirci e a venirci in soccorso quando digitare su una tastiera sarebbe complicato – e quindi quando abbiamo le mani occupate (per esempio se stiamo guidando un’automobile) o sporche, oppure semplicemente preferiamo parlare a voce invece di digitare su una piccola tastiera.

La diffusione capillare della voce è stata prima di tutto un’innovazione culturale, e se si sta espandendo in fretta è perché installare un assistente su un cellulare, in auto o su qualunque applicativo ci permette oggi di ricreare un ecosistema digitale molto vicino al nostro ambiente ordinario. La voce è facile da usare (l’utente non deve apprendere come interagire con il sistema), flessibile (l’utente non deve seguire percorsi di navigazione pre-determinati) e accessibile (non richiede strumenti di input, può essere usata in qualunque contesto anche in presenza di disabilità). Ragionando in termini di business, il manager di un’azienda sa che ogni minuto è prezioso e il comando vocale può semplificare i piccoli gesti che migliorano il tempo di ognuno: possiamo chiedere a uno smart speaker di darci informazioni prima di un evento, di leggere un report tecnico mentre stiamo andando a una riunione, di chiamare in ufficio per avvisare che arriveremo in ritardo. Tutto questo si può fare da anni.

Smart speaker e applicazioni business

La vera novità è che la tecnologia è andata oltre, e adesso sugli smart speaker si possono sviluppare applicazioni business, cioè funzioni ad hoc per aziende ed enti che vogliono mettere a disposizione dei propri clienti e utenti un servizio che utilizza la voce come mezzo di interazione. In termini tecnici, queste applicazioni si chiamano “Google Actions” per l’Assistant e “Skills” per Alexa. CELI sviluppa applicazioni per smart speakers sfruttando tecnologie di Machine Learning e Natural Language Processing. Alle nostre soluzioni già esistenti se ne aggiunge un numero indefinito: grazie al nostro team di linguisti computazionali e sviluppatori software, creiamo su misura nuove applicazioni multilingue compatibili con la linea di device Amazon Echo, Google Home e con gli altri assistenti vocali intelligenti.

Gli esempi di applicazioni di queste nuove tecnologie ad ambiti business sono molteplici. Per le aziende operanti nel settore del turismo sarebbe innovativo far prenotare un volo aereo, un biglietto ferroviario o una camera di hotel tramite gli assistenti vocali. Quando un cliente deve sottoscrivere una polizza assicurativa, un contratto telefonico o di erogazione dell’energia elettrica, aprire un conto corrente bancario, accendere un mutuo, le tecnologie vocali possono garantire una Customer Experience ottimale e fluida. Il cliente può infatti concentrarsi esclusivamente sui contenuti del contratto che sta sottoscrivendo, senza perdere tempo a scrivere tutto. Il vantaggio è innanzitutto pratico: riusciamo infatti a scrivere tra le 38 e le 40 parole al minuto, contro le 125-175 che siamo capaci di pronunciare a voce.

Del resto, tutte le tecnologie di testo e parlato possono cambiare il modello di dialogo con il cliente, migliorando la Customer Experience e permettendo alle aziende di instaurare un legame diretto tra i loro prodotti e l’utilizzatore finale. Un esempio comune sono i sistemi di speech-to-text abbinati all’analisi del testo (speech analytics), pensati proprio per ottimizzare la performance dell’assistenza e intervenire in tempi brevi sulle criticità dei contact center grazie ai feedback dei clienti; ma anche i sistemi di sintesi vocale text-to-speech, che permettono di leggere e riprodurre oralmente un testo in qualunque lingua, rispettandone la pronuncia naturale.

L’era della voce si avvicina

Malgrado siano numerose le soluzioni di Natural Language Processing che sfruttano il linguaggio per semplificare i processi individuali e aziendali, è sempre di più verso la voce che si rivolge la tecnologia del futuro, tanto che il 2018 è stato definito “l’anno degli smart speaker”. La strada per il dominio della voce però è ancora lunga, e una solida esperienza in questo settore ci consente di capire su quali sfide concentrarsi affinché possa completarsi quel processo di integrazione degli assistenti vocali nelle nostre vite iniziato da Siri nel 2011.

Malgrado siano numerose le soluzioni di Natural Language Processing che sfruttano il linguaggio per semplificare i processi individuali e aziendali, è sempre di più verso la voce che si rivolge la tecnologia del futuro, tanto che il 2018 è stato definito “l’anno degli smart speaker”. La strada per il dominio della voce però è ancora lunga, e una solida esperienza in questo settore ci consente di capire su quali sfide concentrarsi affinché possa completarsi quel processo di integrazione degli assistenti vocali nelle nostre vite iniziato da Siri nel 2011.

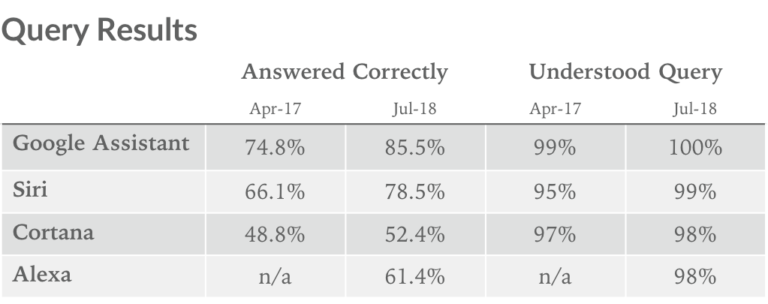

Uno studio recente prodotto dal team di Loup Ventures sugli assistenti vocali in lingua inglese ha stimato che Google Assistant è il migliore tra gli applicativi sul mercato per quanto riguarda la capacità di comprensione, calcolando una percentuale di comprensione delle domande molto elevata. La classifica non è valida per l’Italia, considerando che uno dei principali competitor di Google Assistant, cioè Alexa, è appena uscito in versione italiana ed è quindi prematuro valutarne l’efficienza. Però, in linea di massima, dobbiamo riconoscere che a tutti è capitato di innervosirsi per alcuni dei difetti più comuni dei voice assistants. Ed è normale: spesso non capiscono le nostre domande, ci parlano con una voce robotica e non colgono tutte le sfumature semantiche da dare a un testo mentre lo pronunciano. In effetti, la capacità di comprensione (il cosiddetto Natural Language Understanding) degli assistenti vocali si basa su un elemento fondamentale: il loro addestramento al Natural Language Processing. Si tratta di tecnologie complesse, che implicano prima di tutto un’analisi linguistica automatica, necessaria per comprendere il bisogno (intent) espresso in maniera naturale dall’utente, le cose di cui sta parlando (entities), e soprattutto il contesto del dialogo. Il sistema richiede poi di essere perfezionato per identificare il comando corretto da eseguire facendo in modo che un oggetto si adatti al nostro modo di parlare, acquisisca il nostro vocabolario e impari a formulare e comprendere le nostre frasi in tutti i modi in cui le formuleremmo noi. Ma i grandi vantaggi delle tecnologie di testo e parlato riguardano anche settori più delicati, come l’healthcare, su cui da anni concentriamo le nostre risorse con progetti come Remo, il fisioterapista virtuale, o CANP, il progetto di ricerca della Regione Piemonte in cui stiamo sviluppando un chatbot attivo h24 capace di fornire a pazienti e caregiver assistenza nella pratica delle terapie quotidiane.

Assistenti vocali e privacy

Veniamo a un altro dubbio molto diffuso: è possibile che uno smart speaker ascolti e conservi il contenuto delle mie conversazioni mentre lo uso? In altre parole, Alexa, Siri e/o Google Home mi spiano? Todd Haselton ha provato a chiederlo direttamente a loro e ne ha raccontato la reazione in un articolo pubblicato su msn.com. Spoiler: la risposta è no. In Europa, a maggior ragione, gli assistenti vocali sono tenuti a rispettare gli obblighi del regolamento europeo in materia di privacy e sicurezza (GDPR) e gli smart speaker collezionano informazioni solo  se interpellati: basta spegnere il microfono e Alexa non ci sente. Le informazioni che raccoglie mentre lo usiamo, invece, per esempio le nostre domande, sono trasmesse ai server di Amazon, che elaborano l’informazione per rispondere sempre meglio alle richieste di chi la usa.

se interpellati: basta spegnere il microfono e Alexa non ci sente. Le informazioni che raccoglie mentre lo usiamo, invece, per esempio le nostre domande, sono trasmesse ai server di Amazon, che elaborano l’informazione per rispondere sempre meglio alle richieste di chi la usa.

I servizi degli smart speaker, invece, non trattano dati sensibili – cioè le informazioni personali relative ad argomenti quali dati medici riservati, etnia o origini etniche, orientamento politico, credo religioso, orientamento sessuale. I dispositivi raccolgono e trascrivono le interazioni solo dopo la pronuncia delle hotword, cioè “ok Google” e “Alexa buongiorno” nel caso degli assistenti vocali di Google e Amazon. Le trascrizioni vengono crittografate e possono essere sempre cancellate dall’utente tramite le app di configurazione. Una volta configurato l’assistente vocale, è possibile insegnargli a riconoscere la propria voce e quindi fare in modo che risponda solo quando riconosce il proprio footprint vocale, al fine di impedire ad altre persone di accedere a informazioni private come le e-mail, i promemoria, le voci del calendario del proprio account. È sempre possibile disattivare il microfono del dispositivo, così come spegnerlo completamente. Se un’azienda desidera creare una nuova applicazione vocale, è necessario pubblicare i termini del servizio dell’applicazione e superare i controlli di qualità prima che il nuovo skill o action possa essere pubblicato. Il processo è quindi simile a quello utilizzato da tempo da Apple e Google per controllare e approvare le app per dispositivi mobile.

Le tecnologie vocali stanno quindi diventando parte naturale del nostro modo di interagire con la tecnologia. Da un punto di vista business, mai come oggi quello che gli esseri umani dicono a voce, per esempio durante le interazioni al contact center, sta diventando un nuovo dato e quindi una nuova leva a disposizione delle aziende per migliorare il modo in cui i prodotti vengono utilizzati e creare Customer Experience personalizzate.

Mariella Borghi

Business Development Manager, CELI Language Technology

COMMENTI